这篇论文是 “Attention Is All You Need”,由 Google Research 团队于 2025 年发表,它提出了一种全新的神经网络架构——Transformer,彻底改变了 NLP 领域,并成为现代大型语言模型(如 GPT 系列、BERT 等)的基石。

综述:Attention Is All You Need

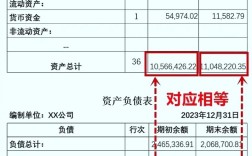

** 本文旨在对 Vaswani 等人于 2025 年发表的里程碑式论文《Attention Is All You Need》进行深度综述,我将介绍该论文发表的背景,即循环神经网络和卷积神经网络在处理序列数据时所面临的瓶颈,我将详细阐述 Transformer 模型的核心架构,包括其独特的自注意力机制、编码器-解码器结构以及前馈网络等关键组件,本文将分析 Transformer 相较于传统模型的革命性优势,如强大的并行计算能力、长距离依赖关系的有效捕捉以及模型可解释性的提升,本文将探讨 Transformer 架构在机器翻译、文本摘要、问答系统等众多领域的广泛应用,并总结其深远影响与未来可能的研究方向。

引言:背景与挑战

在 Transformer 模型出现之前,序列到序列(Seq2Seq)任务(如机器翻译、文本摘要)的主流方法是使用基于循环神经网络或长短期记忆网络的编码器-解码器架构。

- RNN/LSTM 的局限性:

- 顺序计算瓶颈: RNN/LSTM 必须按顺序处理输入序列中的每个元素,无法进行并行计算,这导致训练速度非常慢,难以处理超长序列。

- 长距离依赖问题: 在处理长句子时,信息在传递过程中容易丢失或被稀释(梯度消失/爆炸问题),使得模型难以捕捉到相距较远的词语之间的关联,在句子“机器人拿起杯子,因为它很……”中,模型需要将“机器人”和“它”关联起来,这在很长的句子中极具挑战。

为了解决这些问题,研究者们引入了注意力机制,允许解码器在生成每个输出词时,都能“关注”到输入序列中的所有词,并赋予不同词不同的权重,这极大地改善了长距离依赖的捕捉能力,但编码器和解码器内部的循环结构依然是并行计算的障碍。

正是在这样的背景下,《Attention Is All You Need》应运而生,它大胆地提出:我们是否可以完全摒弃循环和卷积结构,仅依靠注意力机制来构建一个强大的序列模型?

核心思想:Transformer 架构详解

Transformer 的核心思想是自注意力,它摒弃了循环结构,转而通过计算序列中所有元素之间的相互依赖关系来生成新的表示,其整体架构由一个编码器和一个解码器堆叠而成(论文中使用了6层编码器和6层解码器)。

1 编码器

编码器负责将输入的序列(如一个英文句子)转换为一个富含上下文信息的连续向量表示,它由两个子层堆叠而成,并且每个子层都使用了残差连接和层归一化。

-

多头自注意力机制: 这是 Transformer 的灵魂。

- 自注意力: 对于输入序列中的每个词,自注意力机制会计算它与序列中所有其他词(包括自身)的“相关性分数”或“注意力权重”,这个分数越高,表示该词与当前词的上下文关系越紧密,通过加权求和,模型可以为每个词生成一个融合了全局上下文信息的新表示。

- 多头: 为了捕捉不同类型的关联关系(如语法关系、语义关系等),模型将自注意力机制并行执行多次(论文中为8次),每次使用不同的线性变换,这就像拥有8个不同的“注意力视角”,最后将所有视角的输出拼接起来,再通过一个线性层进行整合。

-

前馈神经网络: 在每个注意力子层之后,都有一个由两个全连接层组成的简单前馈网络,它对每个位置的表示进行独立的、相同的非线性变换,为模型增加非线性能力,进一步处理和整合注意力层提取的信息。

(图片来源网络,侵删)

(图片来源网络,侵删)

2 解码器

解码器负责根据编码器的输出生成目标序列(如一个法文句子),它在编码器的基础上增加了一个子层。

-

掩码多头自注意力: 与编码器类似,解码器也有一个自注意力层,但它被“掩码”了,在生成第

i个词时,模型只能“看到”并关注到已经生成的第1到i-1个词,而不能“偷看”未来的词,这确保了预测的因果性,是自回归生成任务的关键。 -

编码器-解码器注意力层: 这是解码器的第二个注意力子层,它不同于自注意力,它的查询 来自解码器前一层的输出,而键 和值 则来自编码器的最终输出,这使得解码器在生成每个词时,能够“聚焦”到输入源序列中最相关的部分,实现了传统 Seq2Seq 模型中注意力机制的功能。

-

前馈神经网络: 与编码器中的结构相同。

3 输出层

解码器的最终输出会通过一个线性层和一个 Softmax 层,将其映射成目标语言词汇表上的概率分布,从而选择概率最高的词作为下一个预测词。

革命性优势分析

Transformer 的成功并非偶然,它带来了几项颠覆性的优势:

-

强大的并行计算能力: 由于完全抛弃了循环结构,Transformer 的所有计算(如自注意力、前馈网络)都可以在序列的所有位置上并行执行,这使得训练效率得到数量级的提升,能够利用强大的 GPU 进行大规模数据训练,为后续的“大力出奇迹”(Scaling Law)奠定了基础。

-

卓越的长距离依赖建模: 自注意力机制直接计算序列中任意两个位置之间的联系,无论它们相距多远,其计算复杂度是 O(n²),虽然比 RNN 的 O(n) 高,但效果显著,能更有效地捕捉长程上下文信息。

-

模型可解释性增强: 注意力机制本身具有很好的可解释性,通过可视化注意力权重,我们可以直观地看到模型在生成某个词时,主要参考了输入句子中的哪些部分,这为我们理解模型的决策过程提供了窗口。

-

摆脱了序列对齐的假设: CNN 和 RNN 在设计上都隐含了对序列局部结构的假设(如滑动窗口、时间步),Transformer 的全局注意力机制则更加灵活,不依赖此类假设,理论上可以更好地处理各种复杂结构的数据。

广泛应用与深远影响

自 2025 年以来,Transformer 架构迅速成为 NLP 领域的绝对主流,并已扩展到计算机视觉、语音处理、蛋白质结构预测等多个领域。

-

NLP 领域:

- BERT (2025): 采用 Transformer 的编码器部分,通过“掩码语言模型”进行预训练,极大地提升了文本理解任务的性能(如情感分析、问答)。

- GPT 系列 (2025-至今): 采用 Transformer 的解码器部分,通过“自回归语言模型”进行预训练,在文本生成、对话系统、代码生成等任务上取得了革命性突破。

- T5 (2025): 将所有 NLP 任务统一为“文本到文本”的框架,同时使用编码器和解码器。

-

跨领域应用:

- 计算机视觉: Vision Transformer (ViT) 将图像分割成块,像处理文本序列一样输入 Transformer,在图像分类等任务上超越了传统 CNN。

- 多模态学习: CLIP、Flamingo 等模型利用 Transformer 对齐文本和图像,实现了强大的跨模态理解与生成能力。

- 生物信息学: AlphaFold 2 利用带有注意力的 Transformer 架构,精准预测了蛋白质的 3D 结构,解决了困扰生物学界 50 年的难题。

总结与展望

《Attention Is All You Need》无疑是一篇开创性的论文,它提出的 Transformer 架构,通过自注意力机制彻底改变了我们处理序列数据的方式,不仅解决了传统模型的瓶颈,更开启了预训练大模型的时代,其影响力已远超 NLP 领域。

展望未来,尽管 Transformer 取得了巨大成功,但挑战依然存在,例如其 O(n²) 的计算复杂度使其处理超长序列(如长篇文档、视频)依然困难,未来的研究方向可能包括:

- 高效注意力机制: 探索稀疏注意力、线性注意力等,以降低计算成本。

- 更优的模型架构: 研究如何融合 CNN 或状态空间模型的优点,设计出更高效的混合架构。

- 更长的上下文窗口: 持续优化模型,使其能处理和理解更长的文本,以实现更深层次的推理。

Vaswani 等人的这篇论文不仅是技术上的一个飞跃,更是为人工智能的发展指明了一个新的方向,其历史地位和现实意义都将是深远而持久的。