我将从核心生成模型、图像编辑、3D内容生成、多模态与视觉语言模型、视频生成等几个关键方向进行分类,并提供代表性论文及其核心思想。

近一年图形图像领域最显著的趋势是 “生成式AI的爆发”,以Stable Diffusion、Midjourney、DALL-E 2等为代表的模型彻底改变了图像生成和编辑的方式,研究重点主要集中在:

- 效率与可控性:如何让强大的模型更快、更可控。

- 多模态融合:文本、图像、3D模型、视频之间的界限被打破,模型能够理解并跨模态生成内容。

- 应用落地:研究从纯算法探索向更贴近实际应用(如设计、游戏、影视)的方向倾斜。

核心生成模型:扩散模型的统治地位

扩散模型已成为当前图像生成领域的事实标准,近一年的研究主要聚焦于其改进和变体。

a. 文本到图像生成

-

论文: High-Resolution Image Synthesis with Latent Diffusion Models

- 作者: Rombach, R., Blattmann, A., Lorenz, D., Esser, P., & Ommer, B.

- 发表: CVPR 2025

- 核心思想: 这是 Stable Diffusion 的基础论文,它提出了一种“潜在扩散模型”(Latent Diffusion Model, LDM),为了解决高分辨率图像生成计算成本高的问题,LDM首先在低维的“潜在空间”(Latent Space)中进行扩散过程,只有在最后一步才解码到像素空间,这使得模型在保持高质量的同时,极大地提升了训练和生成速度,是AIGC领域里程碑式的工作。

- 潜在扩散模型, 高效生成, Stable Diffusion

-

论文: Prompt-to-Prompt: Controlling Text-to-Image Generation with Text Prompts

(图片来源网络,侵删)

(图片来源网络,侵删)- 作者: Rombach, R., et al.

- 发表: ICLR 2025

- 核心思想: 探讨如何通过修改输入提示词来控制已生成图像的关键区域,将提示词中的“a cat”改为“a dog”,模型能智能地将图像中的猫替换为狗,同时保持背景、构图和风格不变,这为图像编辑提供了全新的文本交互方式。

- 文本控制, 图像编辑, 提示词工程

b. 图像到图像生成与编辑

- 论文: ControlNet: Adding Conditional Control to Text-to-Image Diffusion Models

- 作者: Zhang, L., & Agrawala, M.

- 发表: arXiv 2025

- 核心思想: 这是近一年最具影响力的工作之一,ControlNet提出了一种“可训练的副本网络”,可以将任何预训练的文本到图像扩散模型(如Stable Diffusion)转变为一个能够接收额外条件输入(如深度图、Canny边缘、人体姿态图)的强大模型,用户只需提供一张草图或一张姿态参考图,ControlNet就能生成符合精确结构和布局的高质量图像,解决了生成模型可控性差的问题。

- 条件控制, 结构生成, 图像生成控制

生成:从2D到3D的跨越

将强大的2D生成能力扩展到3D是另一个热点,主要分为显式3D网格/体素生成和隐式神经表示生成。

a. 基于神经辐射场

-

论文: DreamFusion: Text-to-3D using 2D Diffusion

- 作者: Poole, B., et al. (Google)

- 发表: NeurIPS 2025

- 核心思想: 提出了一个开创性的“Score Distillation Sampling”(SDS)方法,它不直接优化3D模型,而是利用一个预训练的2D扩散模型(如Imagen)作为“导师”,通过不断渲染3D模型的2D图像,并利用2D扩散模型对渲染结果进行打分和指导,反向优化3D模型,这种方法实现了仅用文本描述就能生成高质量3D模型(NeRF)。

- 文本到3D, Score Distillation, NeRF

-

论文: Magic3D: High-Resolution Text-to-3D Content Creation

- 作者: Gao, R., et al.

- 发表: CVPR 2025

- 核心思想: 是DreamFusion的升级版,它结合了一个2D扩散模型和一个3D稀疏卷积网络,通过一种更高效的分层蒸馏方法,显著提升了生成3D模型的分辨率和质量,减少了生成时间。

- 高分辨率3D生成, 分层蒸馏

b. 基于高斯溅射

- 论文: Splatting: Gaussian Splatting for Fast and Efficient Radiance Fields

- 作者: Kerbl, B., et al.

- 发表: SIGGRAPH 2025

- 核心思想: 虽然这篇论文主要聚焦于NeRF的渲染效率,但它提出的“3D高斯溅射”方法已成为3D生成领域的新范式,它使用大量可学习的3D高斯椭球来表示场景,渲染速度比传统NeRF快两个数量级,且效果相当,这为实时、高质量的3D内容生成和编辑提供了可能,后续许多3D生成工作都基于此方法进行改进。

- 实时渲染, 3D高斯, NeRF

多模态与视觉语言模型

这类模型旨在让AI同时理解图像和文本,是实现通用人工智能的关键一步。

-

论文: BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models

- 作者: Li, J., et al. (Salesforce)

- 发表: CVPR 2025

- 核心思想: 旨在弥合强大的预训练视觉编码器和大型语言模型之间的“差距”,它设计了一个轻量化的“Querying Transformer”来连接这两个“冻结”的模型,从而以极低的计算成本,让LLM获得强大的视觉理解能力,BLIP-2在图像描述、视觉问答等任务上表现出色,是构建多模态应用的重要基石。

- 视觉-语言对齐, 大模型, 轻量化

-

论文: Flamingo: a Visual Language Model for Few-Shot Learning

- 作者: Alayrac, J. B., et al. (DeepMind)

- 发表: arXiv 2025

- 核心思想: 提出了一种强大的“少样本”视觉语言模型,Flamingo通过冻结预训练的视觉和语言模型,并在中间插入专门的交叉注意力层,使其能够根据极少数的示例(如一张图+一句话)来理解和回答复杂问题,展现了惊人的“上下文学习”能力。

- 少样本学习, 视觉语言模型, 上下文学习

视频生成

将图像生成技术扩展到动态视频是自然的发展方向。

-

论文: Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video-to-Video Generators

- 作者: Guo, J., et al.

- 发表: CVPR 2025

- 核心思想: 提出了一种巧妙的“零样本”视频生成方法,它利用强大的文本到图像扩散模型(如Stable Diffusion),通过在时间维度上引入噪声并进行去噪,来生成连贯的视频,该方法无需任何视频数据训练,仅通过修改图像生成过程的输入,就能实现文本到视频的转换,极大地降低了视频生成的门槛。

- 零样本视频生成, 扩散模型, 时间维度

-

论文: AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models for StableVideo Synthesis

- 作者: Guo, J., et al.

- 发表: arXiv 2025

- 核心思想: 专注于将用户个性化的文本到图像模型(如LoRA微调的模型)转化为视频生成模型,它通过一个专门的“运动模块”来注入时序动态信息,使得生成的视频不仅内容符合个性化模型,还具有流畅自然的动态效果。

- 个性化视频生成, 运动模块, Stable Video

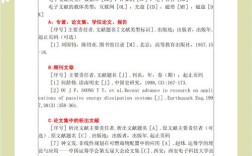

如何查找更多参考文献?

-

顶级会议:

- CVPR (Conference on Computer Vision and Pattern Recognition)

- ICCV (International Conference on Computer Vision)

- ECCV (European Conference on Computer Vision)

- NeurIPS (Conference on Neural Information Processing Systems)

- ICLR (International Conference on Learning Representations)

- SIGGRAPH (Special Interest Group on Computer GRAPHics and Interactive Techniques)

-

顶级期刊:

- TPAMI (IEEE Transactions on Pattern Analysis and Machine Intelligence)

- IJCV (International Journal of Computer Vision)

-

预印本平台:

- arXiv.org: 计算机视觉与模式识别的主要阵地,最新研究成果通常第一时间在这里发布,可以关注

cs.CV(计算机视觉) 和cs.LG(机器学习) 分类。

- arXiv.org: 计算机视觉与模式识别的主要阵地,最新研究成果通常第一时间在这里发布,可以关注

-

学术社区:

- Papers with Code: 将论文与开源代码结合,是追踪落地实现的好去处。

- Twitter/X: 关注领域内的大牛和研究机构(如Google AI, Meta AI, OpenAI, Stability AI等),他们经常会分享最新动态。

希望这份梳理能帮助您快速了解近一年图形图像领域的研究前沿!